Site menu:

Signifikanztests bei Korrelationen

- Vergleich zweier Korrelationskoeffizienten aus unabhängigen Stichproben

- Vergleich zweier Korrelationskoeffizienten aus abhängigen Stichproben

- Prüfung auf lineare Unabhängigkeit: Unterschied von 0

- Unterschied einer Korrelation von einem festen Wert ungleich 0

- Berechnung des zweiseitgen Konfidenzintervalls für Korrelationen

- Fisher-Z-Transformation

- Berechnung des Phi Korrelationskoeffizienten rPhi für Kontingenztabellen

- Mittelung von Korrelationen

- Umrechnung der Effektstärkemaße r, d, η2 (Eta Quadrat) und des Odds Ratio

- Berechnung von Korrelationen

1. Vergleich zweier Korrelationskoeffizienten aus unabhängigen Stichproben

Wurden in verschiedenen Stichproben Zusammenhänge zweier Variablen ermittelt, so lassen sich diese mit dem folgenden Online-Rechner vergleichen und auf Unterschiedlichkeit testen. Hier ein fiktives Beispiel: Nehmen wir an, dass untersucht werden soll, ob bei Männern ein stärkerer linearer Zusammenhang zwischen Alter und Einkommen besteht als bei Frauen. Man könnte also an einer Stichprobe von z. B. 930 Männern und 980 Frauen jeweils Alter und Einkommen erfassen und für beide Geschlechter die Korrelation zwischen Alter und Einkommen berechnen. Die Korrelation könnte beispielsweise bei den Männern r = .38 und bei den Frauen r = .31 betragen. Unterscheiden sich die Korrelationen signifikant?

| n | r | |

| Korrelation 1 | ||

| Korrelation 2 | ||

| Prüfgröße z | ||

| Wahrscheinlichkeit p | ||

(Berechnung nach Eid, Gollwitzer & Schmidt, 2017, S. 577 f.; einseitige Testung)

2. Vergleich zweier Korrelationskoeffizienten aus abhängigen Stichproben

Wurden mehrere Korrelationen an der selben Stichprobe erhoben, so lässt sich diese Abhängigkeit in den Daten zusätzlich nutzen, um noch mehr Informationen auszuschöpfen. Das kann z. B. bei folgenden fiktiven Szenarien der Fall sein:

- Es wurden 85 Kinder der 3. Klassenstufe mit einem Intelligenztest (1), einem Mathematiktest (2) und einem Lesetest (3) untersucht. Die Intelligenz korreliert mit der Mathematikleistung zu r12 = .53, mit der Leseleistung zu r13 = .41. Die Korrelation zwischen Mathematik und Lesen beträgt r23 = .59. Korreliert die Intelligenz höher mit Mathematik oder mit Lesefertigkeiten?

- In einer Untersuchung zum Studienerfolg wurden Leistungen der Studierenden in einer Abschlussklausur (n=296) mit dem Lernaufwand und der Häufigkeit der Anwesenheit korreliert. Mit dem Lernaufwand korreliert die Abschlussnote zu r12 = .67 und mit der Anwesenheit zu r13 = .48. Lernaufwand und Anwesenheit korrelieren zu r23 = .19. Unterscheiden sich die Zusammenhänge zwischen Studienerfolg und Lernaufwand bzw. Anwesenheit?

| n | r12 | r13 | r23 |

| Prüfgröße z | |||

| Wahrscheinlichkeit p | |||

(Berechnung nach Eid et al., 2017, S. 578 f.; einseitige Testung)

3. Prüfung auf lineare Unabhängigkeit: Unterschied von 0

Mit dem folgenden Rechner können Korrelationen dahingehend geprüft werden, ob sie signifikant von 0 unterschiedlich sind. Der Test basiert auf der Student's t-Verteilung mit n - 2 Freiheitsgraden. Beispiel: Es wurde bei 18 Männern die Nasenlänge und Schuhgröße erhoben und miteinander korreliert. Die Korrelation beträgt r = .69. Besteht wirklich ein Zusammenhang?

| n | r |

| Prüfgröße t | |

| Wahrscheinlichkeit p (einseitig) | |

| Wahrscheinlichkeit p (zweiseitig) |

(Berechnung nach Eid et al., 2017, S. 573)

4. Unterschied einer Korrelation von einem festen Wert ungleich 0

Mit dem folgenden Rechner können Korrelationen dahingehend geprüft werden, ob sie sich signifikant von einem bestimmten Wert unterschiedlich sind. Der Test erfolgt approximativ mittels einer Fisher-Z-Transformation.

| n | r | ρ (Wert, gegen den die Korrelation geprüft werden soll) |

| Prüfgröße z | ||

| Wahrscheinlichkeit p | ||

(Berechnung nach Eid et al., 2017, S. 573f.; zweiseitige Testung)

5. Berechnung des zweiseitgen Konfidenzintervalls für Korrelationen

Das Konfidenzintervall gibt den Bereich an, in dem eine Korrelation mit einer bestimmten Wahrscheinlichkeit liegt. Die Wahrscheinlichkeit wird durch den Konfidenzkoeffizienten spezifiziert. Das Konfidenzintervall wird umso größer, je höher der Konfidenzkoefizient ist.

| n | r | Konfidenz- koeffizient |

|

| Standardfehler (SE) | |||

| Konfidenzintervall | |||

Berechnung nach Bonnett & Wright (2000), siehe auch Gnambs (2022)

6. Fisher-Z-Transformation

Das Fisher-Z-Transformation konvertiert Korrelation in eine annähernd normalverteilte Größe. Sie kommt bei vielen Berechnungen mit Korrelationen zur Anwendung, z. B. wenn der Mittelwert von Korrelationen ausgerechnet werden soll. Der folgende Rechner ermöglicht die Transformation von Korrelationen in Fisher-Z-Werte und die Rücktransformation.

| Wert | Transformation | Ergebnis |

7. Berechnung des Phi Korrelationskoeffizienten rPhi für Kontingenztabellen

rPhi ist ein Maß für den Zusammenhang zwischen binären Daten. Oft handelt es sich um Fallzahlen, z. B. die Anzahl an Männern und Frauen, die einen Test bestehen oder nicht bestehen. Das Maß wird ebenfalls Kontingenzkoeffizient oder Yule's Phi genannt. Die Transformation zu dCohen erfolgt mit dem Effektstärkerechner.

| Gruppe 1 | Gruppe 2 | |

| Kategorie 1 | ||

| Kategorie 2 | ||

| rPhi | ||

| Effect Size dcohen | ||

8. Mittelung von Korrelationen

Aufgrund der schiefen Verteilung von Korrelationskoeffizienten (vgl. Fisher-Z-Transformation), kann aus Korrelationen nicht einfach der Mittelwert gebildet werden. Üblicherweise werden Korrelationen deshalb zunächst Fisher-Z-transformiert und anhand der Fallzahlen gewichtet. Der Durchschnitt wird anschließend wieder invers Fisher-Z-transformiert. Eid et al. (2017, S. 574f.) schlagen unter Verweis auf Simulationsrechnungen vor, stattdessen eine Korrektur nach Olkin & Pratt (1958) zu verwenden, der eine bessere Schätzung der mittleren Korrelation darstellen würde.

| rFisher Z | rOlkin & Pratt | |

Bitte tragen Sie in Spalte A die Korrelationen (mit Dezimalpunkt) ein, in Spalte B die Fallzahlen. Sie können auch Listen an Werten aus Tabellenkalkulationen kopieren. Klicken Sie abschließemd auf "OK" um die Berechnung zu starten. Zur Veranschaulichung ist bereits ein Beispiel eingetragen.

9. Umrechnung der Effektstärkemaße r, d, η2 (Eta Quadrat) und des Odds Ratio

Korrelationen sind eine Form von Effektstärke, d. h. sie geben an, wie deutlich ein empirischer Effekt ausgeprägt ist. Es existieren noch eine Reihe weiterer Effektstärkemaße, von denen dCohen am bekanntesten ist. Die verschiedenen Effektstärkemaße können ineinander umgerechnet werden. Bitte besuchen Sie hierfür Berechnung von Effektstärken.

10. Berechnung von Korrelationen

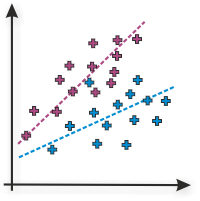

Abschließend finden Sie hier die Möglichkeit, lineare Korrelationen zu berechnen. Der Online-Rechner berechnet die Pearson- oder Produkt-Moment-Korrelation zweier Variablen. Bitte tragen Sie in Spalte A die Ergebnisse von Variable 1 und in Spalte 2 die Ergebnisse von Variable 2 ein. Verwenden Sie bitte Dezimalpunkte. Sie können auch Listen an Werten aus Tabellenkalkulationen kopieren. Klicken Sie abschließemd auf "OK" um die Berechnung zu starten. Zur Veranschaulichung ist bereits ein Beispiel für stark positive Korrelation eingetragen.

| Daten |

lineare Korrelation rPearson |

Determinations- koeffizient r2 |

Interpretation |

|

|

Literatur

Viele der hier implementierten Hypothesentests basieren auf der Darstellung von Eid und Kollegen (2017). Zur Generierung der t-Verteilung für den Test von Korrelationen gegen einen statischen Wert wurde auf die Bibliothek jStat zurückgegriffen. Zur Darstellung der Tabellenkalkulation wird Handsontable verwendet.

- Bonnett, D. G., & Wright, T. A. (2000). Sample size requirements for estimating Pearson, Kendall, and Spearman correlations. Psychometrika, 65(1), 23-28. doi: 10.1007/BF0229418

- Eid, M., Gollwitzer, M., & Schmitt, M. (2017). Statistik und Forschungsmethoden Lehrbuch (5. korr. Auflage). Weinheim: Beltz.

- Gnambs, T. (2022, April 6). A brief note on the standard error of the Pearson correlation. https://doi.org/10.31234/osf.io/uts98

Zitierfähige Quelle: Lenhard, W. & Lenhard, A. (2014). Signifikanztests bei Korrelationen. verfügbar unter: https://www.psychometrica.de/korrelation.html. Bibergau: Psychometrica. DOI: 10.13140/RG.2.1.2954.1367